Много лет назад, в 2000-м году, я написал свою первую книжку «Обнаружение атак». Да и вообще в те годы я достаточно активно занимался этой тематикой. С тех пор я регулярно отслеживаю последние веяния в этой области. И вот вчера, проглядывая материалы РусКрипто 2015 я наткнулся на СПИИРАНовской доклад «Построение нейросетевой и иммуноклеточной системы обнаружения вторжений», который описывал отечественное исследование, в котором ставились следующие задачи:

- Создание гибридной схемы обнаружения и

классификации сетевых атак - Программная реализация нейросетевого и иммуноклеточного модулей для обнаружения атак

- Сравнение предложенных подходов по критерию эффективности распознавания атак.

Дай, думаю, изучу, куда ушла отечественная мысль за 15 лет? Изучил 🙁

Авторы, сделав традиционный вывод, что сигнатурные системы обнаружения атак неэффективны и нужно применять адаптивные методы, решили пойти проторенным путем, которым разные исследовали ходят уже лет 20 с лишним. Они решили применить для целей обнаружения атак нейросети и карты Кохонена. Ну допустим. Хотя за 20 лет ни одной коммерчески успешной системы, построенное на этих принципах, так и не появилось. Почему-то все системы до сих пор строятся именно на базе сигнатурных (или модифицированных) методов и большинство их создателей стараются снизить время между обнаружением атаки и разработки сигнатуры для нее.

Адаптивные методы тоже применяются, но для упрощения и повышения скорости работы они обычно используют анализ поведения приложений/процессов/файлов в песочнице. А дальше идет сравнение, насколько собранные параметры выпадают в заранее заданные пороговые значения. Работают данные методы неплохо, хотя зависимость от человеческого фактора велика и многие исследования ведутся именно в направлении автоматизации ряда задач (мы даже для этого купили за последнее время пару компаний — Cognitive Security и ThreatGRID).

В исследовании СПИИРАН, на которое, кстати, и денег было выделено по разным грантам, почему-то использовались устаревшие и совершенно неприемлемые в современных реалиях данные.

Почему используются тестовые данные 90-х годов? Почему нельзя взять Wireshark или TCPdump и записать реальный сетевой трафик, который и пускать на вход нейросети? Почему нельзя использовать тот же Metasploit вместо сканера SATAN 90-го года?

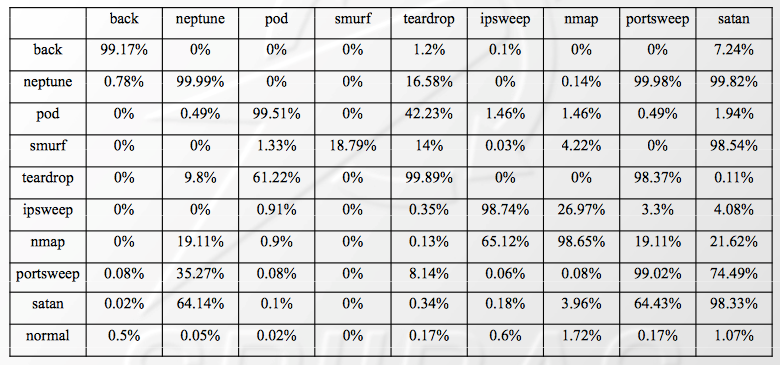

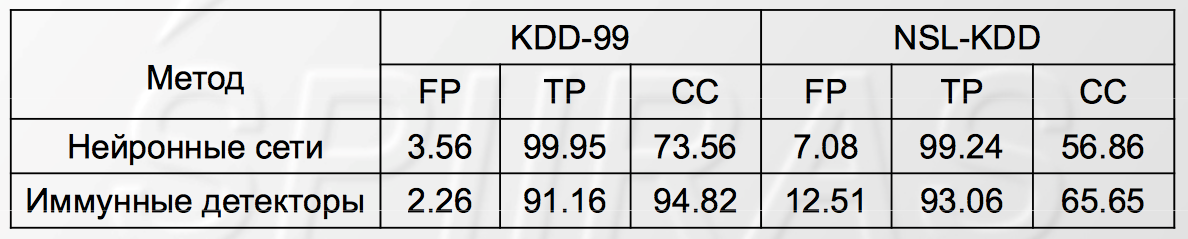

Это нетрудно — займет всего несколько часов работы любого сниффера. Ну или несколько дней, если хочется получить более репрезентативную выборку. На это даже бюджетных денег особо не надо. А вот результат должен стать гораздо более интересным и приближенным к реальности. Правда, врядли он будет близким к 99,95% (TP — показатель обнаружения, FP — показатель ложных срабатываний), как в таблице.

Поддержка научных исследований в области ИБ, о которых так много говорилось на РусКрипто, это конечно классно, но все-таки исследования должны быть более релевантными, как мне кажется. Особенно за бюджетные деньги.

но все-таки исследования должны быть более релевантными, как мне кажется. Особенно за бюджетные деньги.

Чем будет больше открытости в работах, тем меньше будет изобретений велосипедов.

То, что такие исследования перестали снабжать соответствующим грифом — уже прогресс по сравнению с 90-ми… Так что потихоньку куда-то движемся.

Жаль, что только сейчас ознакомился. Передам Ваши пожелания научному руководителю провинившегося аспиранта Браницкого.

Поработаю за "буфер обмена информацией" вот статья по заинтересовавшей Вас тематике его научного руководителя:

http://www.mathnet.ru/links/f7c231153be2fd1d5cf06e0f1bf03bc5/trspy528.pdf

А как моделирование атак из статьи Котенко связано с построением нейросетевой системы обнаружения атак?

Мой комментарий, уважаемый мэтр, относится к первому абзацу Вашей заметки. Цитирую: "Много лет назад, в 2000-м году, я написал свою первую книжку "Обнаружение атак". Да и вообще в те годы я достаточно активно занимался этой тематикой."

Требую реабилитации аспиратнта Браницкого, он даже воспользовался книгой уважаемого мэтра, как источником:

http://proceedings.spiiras.nw.ru/ojs/index.php/sp/article/view/3267

Использовать мою книжку 2000-го года — это конечно классно, но за что реабилитировать? Были новые шаблоны сетевого трафика загнаны на разработанный прототип системы? Или еще что-то?

Да, увидел у него "гибридные решения по комбинированию отдельных решателей". Мы ведь все стоим на плечах гигантов, глядишь накомбинирует)

Ну пусть загонит PCAPы из моего блога на прототип и опубликует результаты