На прошлой неделе произошло два события, касающихся искусственного интеллекта — известная депутат Ирина Яровая заявила о каннибализме со стороны создателей ИИ, а мне довелось провести вебинар, посвященный применению ИИ в кибербезопасности. Про каннибализм мы, к счастью, не говорили (тут я не специалист), а вот про гораздо более близкую мне тему, к которой я неоднократно обращался в своих выступлениях и заметках (под этой заметкой вы найдете список других заметок в этом блоге на эту тему), побеседовали с экспертами из Positive Technologies и Ростелеком-Солар достаточно подробно.

А кто сегодня потребляет энергию? Люди? Значит, что нужно уменьшить количество людей. Чтобы осталась маленькая группа, обладающая властью и имеющая возможность использовать все это во благо себе с помощью искусственного интеллекта."

По традиции некоторые мои мысли и тезисы по результатам эфира, запись которого можно посмотреть в самом низу поста:

- Помимо DDoS, вредоносного кода, спама, фишинговых и DGA-доменов, социального инжиниринга, фрода, компрометации утечек и дипфейков, машинное обучение умеют детектировать еще и утечки информации, в том числе реализуемые и посредством съемки экрана монитора, а также различные изображения — фото карт, паспортов и т.п. Неплохо современные ML-модели умеют распознавать текст, его смысл и содержание. Например, ML может отделять достаточно безобидную фразу «Регулярно меняйте ваш пароль» от «Ваш пароль от учетной записи — BitchBeachDrink», которая уже является нарушением политики ИБ (передача паролей в открытом виде) или «Введите ваш пароль». Также ML может распознавать голос, анализировать поведение пользователей, выявлять в нем аномалии, выявлять уязвимости и т.п. В целом сегодня машинное обучение может решать любые задачи, но не вс

- Если машинные модели уже обыгрывают человека в компьютерных играх, например, Dota2, то что мешает с помощью ML автоматизировать тесты на проникновение? Причем за последние пару лет технологии действительно скакнули далеко вперед и сегодня вполне можно представить себе ситуацию, когда кто-то обучить модель на большом объеме обучающей выборки, полученной на каком-либо CTF или The Standoff с последующим использованием полученных «знаний» в генерации тестов на проникновение.

- Готовых и публичных датасетов для обучения моделей ML в области ИБ почти нет. Есть тот же Kaggle, но датасеты на нем подходят только для узких задач (например, работы с текстами и изображениями) и только для первичной проверки гипотез. В Интернете можно найти отдельные датасеты для целей ИБ, но они, как правило, устаревшие и требуют существенной доработки. Большинство же датасетов сегодня создаются самими вендорами (ну или заказчиками, если они сами пишут решения по ИБ на базе ML). Например, датасет изображений человека, держащего телефон перед экраном монитора. Отсюда простой вывод — в обозримом будущем датасеты продолжат оставаться ноу-хау разработчиков и не станут публично доступными, так как создание датасета требует времени и усилий и никто не хочет делиться этим бесплатно. Хотя некоторые датасеты по ИБ и могут быть выложены в открытый доступ, в ряде случаев это может быть вообще опасно, так как может быть использовано в неблаговидных целях.

Время обучения модели может занимать от нескольких часов до 1-3 месяца и зависит от объема и интенсивности анализируемых данных.

- Управление датасетами (хранение, защита, версионность, разметка, пополнение, балансировка данных, очистка и т.п.) — это отдельная очень важная тема, о которой обычно мало говорят и от решения которой зависит качество машинного обучения. Кстати, существующий миф о том, что системы ИБ на базе ML не требуют обновления, является именно мифом. Чтобы обнаруживать совсем новые угрозы, все-таки необходимо новые датасеты, новая разметка, а может быть даже и новые модели.

- Также мало говорят о разметке датасетов, в которой молодые и неопытные аналитики часто допускают ошибки, что приводит к последующему снижению качества обнаружения каких-то угроз. Согласно статистике, до 75% всех моделей ML в ИБ базируются на обучении с учителем, то есть требуют соответствующей разметки. Поэтому нужно не только перепроверять сделанную разметку другими специалистами по работе с данными, но и использовать специализированное ПО для разметки. Особенно в ситуациях, когда признаков для разметки несколько тысяч или даже сотен тысяч. А вот для обнаружения аномалий обучение с учителем не требуется и для многих моделей на базе кластеризации данных разметка не нужна. Неким промежуточным вариантом является автоматизированная разметка. Например, вредоносные файлы можно подавать на вход песочницы, которая сама будет детектировать вредоносное поведения и сама размечать получаемые данные без участия человека.

Прирост качества обнаружения при использовании ML в отличие от «обычных» решений ИБ, может быть кратным, но в конечном счете этот показатель зависит от конкретной задачи (в ряде сценариев без ML обнаружить угрозы вообще не получится).

- Машинное обучение может быть использовать во вредоносных целях — поиска уязвимостей, генерации фишинговых сообщений, профилировании жертв, генерации атак (тех же SQL-инъекций), дипфейков и т.п. Также с помощью искусственного интеллекта можно генерить фейковые новости, компрометирующие как компанию, так и ее руководство.

Современные модели машинного обучения умеют обходить CAPTCHA и reCAPTCHA с точностью выше 85%!

- Атака на датасеты (например, инъекции) возможны, но их применимость зависит от конкретного решения, использующего ML. Для контентных решений это вполне себе способ и от него необходимо защищаться. А вот для систем защиты типа WAF, SIEM, сканер уязвимостей, NDR и т.п. такие атаки малоперспективны, так как если злоумышленник уже смог получить несанкционированный доступ к решению ИБ, то ему и не нужно атаковать датасет в большинстве случаев.

- Место работы ML-движка обычно зависит и от решаемых задач и используемых моделей обучения, которые могут требовать или не требовать избыточных вычислительных ресурсов. Поэтому в отличие от того же блокчейна в режиме Proof-of-Work, требующего интенсивных вычислений, графических карт и электричества, многие ML-решения могут быть запущены на обычном сервере или даже рабочей станции.

Антон Чувакин, GoogleУ вас если нужные данные, но нет правильных моделей. У вас есть правильные модели, но нет нужных данных. Сегодня у вас есть нужные данные (и их слишком много) и правильные (наверное) модели, но нет аналитиков, которые могут свести все это вместе!

Антон Чувакин, GoogleУ вас если нужные данные, но нет правильных моделей. У вас есть правильные модели, но нет нужных данных. Сегодня у вас есть нужные данные (и их слишком много) и правильные (наверное) модели, но нет аналитиков, которые могут свести все это вместе! - Где найти специалиста, который бы был одновременно прокачан и в ИБ и в Data Science. Сегодня это практически невозможно. На практике это обычно тандем специалистов по машинному обучению и по кибербезопасности. Поэтому искать первых надо в сообществах data scientist’ов (например, ODS) или выпускников ВУЗов, которые еще и хотят работать в ИБ, что тоже бывает не всегда. Обучать же ИБшников машинному обучению неразумно (кроме общих концепций).

- Возможна ли полная автоматизация процесса обнаружения угроз и реагирования на инциденты ИБ? 23% слушателей нашего эфира ответили на этот вопрос позитивно и это достаточно хороший показатель. На самом деле работы в этом направлении ведутся и уже существуют прототипы и бета-версии решений (у Google, у Palo Alto, у Positive Technologies, которые позволяют это делать. Правда, пока не для всех абсолютно типов атак, но для многих из них. И машинное обучение играет в решении этой задачи одну из основных ролей.

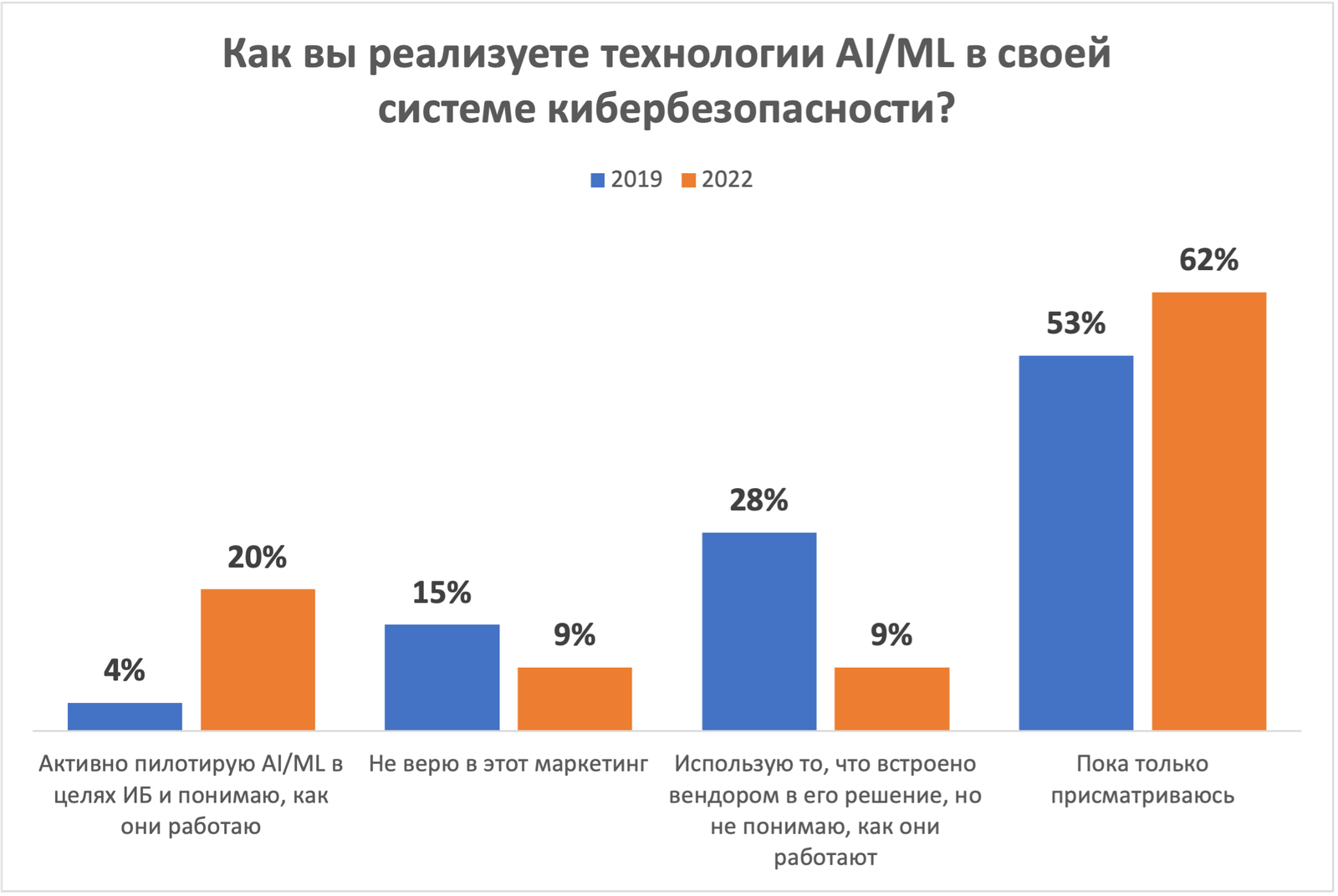

Мы еще много что обсудили в рамках эфира, посвященного применению искусственного интеллекта в кибербезопасности, но я рекомендую его все-таки посмотреть, так как он был настолько насыщен деталями и лайфхаками, что я просто не смогу их все пересказать в виде тезисов. Однако закончить заметку мне хотелось бы одной гистограммой, которая показывает изменение отношение российских ИБшников в части использования машинного обучения для целей кибербезопасности. Разница всего 3 года, а рост тех, кто пилотирует или использует ML в своей работе вырос с 4 до 20%. Это прям позитивно!

Ну а теперь видео самого эфира:

Пока это все похоже на некий маркетинг!

Все равно, все сидят, и обучают армией студентов свои якобы AI, нейросетевые модели…Как такогового AI еще нет…И в ближайщие лет 15 не появится.

Пока нейросети не смогут обучить, самообучаться и самостоятельно собирать данные работа будет полуручная! А когда научаться нейросети все делать самостоятельно — Hello Skynet!

AI в ИБ — это булшит. А вот ML — это вполне работающая схема и примеров его применения в ИБ десятки