Да, ИБ-стартапы (не в России) активно применяют (или заявляют об этом) различные варианты искусственного интеллекта (как правило, машинное обучение) в своих продуктах, делая именно на ни ставку. За прошедшие 6 лет было совершено более двухсот сделок в этой области и рынок кибербезопасности входит в Топ 5 сфер для сделок слияний и поглощений в этой сфере. Очень активны в этой области различные инвестиционные фонды, которые, как мне кажется, просто хотят нажиться на горячей теме, чем продвинуть ее в массы. Хотя наличие среди самых активных инвесторов ЦРУшной In-Q-Tel заставляет думать и об обратном.

Но какие наблюдения у меня родились в процессе подготовки различных версий презентации по ИИ и кибербезопасности? Их несколько. Во-первых, многие «апологеты» и «евангелисты», похоже, не учили математику в своей юности (или юность их не так далеко от них ушла) и поэтому они почему-то считают, что ИИ — это что-то новое и он вот-вот поработит нас, как Скайнет в «Терминаторе». Но разочарую — этой теме уже с полсотни лет и пока никакого порабощения нас роботами и компьютерами не произошло (и пока нет уверенности, что это произойдет в ближайшем будущем). Я вспоминаю свое обучение в институте по специальности «Прикладная математика» и многое из того, что сегодня преподносят как новое, на самом деле является хорошо забытым старым. Кстати, одна из курсовых у меня была посвящена созданию экспертных систем (да, это еще не Big Data и не совсем ИИ, но многое из области эксертных систем потом перешло в область искусственного интеллекта).

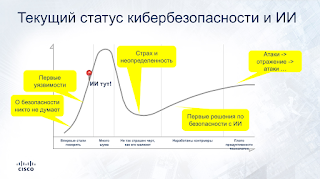

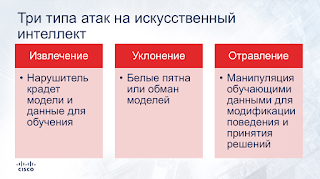

Очень мало где говорится об атаках на искусственный интеллект, позволяющих превратить все новомодные модели в тыкву. Безопасникам же наоборот требуется смотреть на все новомодные штуки именно с прицела «как можно ее обойти» или «как можно использовать ее во вред». Об этом пишут не так уж и много, так как исследователей ИИ в первую очередь интересует положительная сторона их творений (как тут не вспомнить Манхеттенский проект).

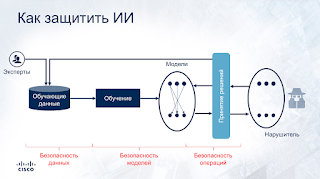

Еще меньшее число исследований говорит о том, как защитить ИИ от негативных направленных воздействий? Как защитить обучающую выборку? Как защитить модели от внедрения некорректных данных или использования «белых пятен» в алгоритмах ИИ? Как обеспечить целостность данных и моделей и защититься от манипуляции с ними? Про SecOps для ИИ тоже мало кто говорит, хотя в этой нише как раз много наработок из традиционной корпоративной сферы.

Наконец, мало говорят о том, как искусственный интеллект может быть использовать во вред, то есть применен для обхода систем защиты. И дело не в банальном обходе CAPTCHA, а в более сложных механизмах уклонения от антивирусов и системы защиты от вредоносного кода, от систем контентной фильтрации, от систем сетевой безопасности. Такие технологии активно тестируются различными сторонами — от хакеров до военных ведомств разных государств, что вновь обращает нас к мысли, что не стоит так уж бездумно бросаться в тему искусственного интеллекта. Вот уж, кстати, дурацкое название. Кому в голову пришла мысль перевести «intelligence» как «интеллект» (при наличии английского «intellect»)?

К чему это я? Какой-то конкретной цели заметка не преследует. Скорее это наблюдение, которым я решил поделиться и которое мне не хотелось терять в суматохе. В любом случае стоит помнить о здравом скепсисе, который должен сопровождать безопасника при изучении/внедрении новых технологий. Без этого жить становится сложно.